站长之家(ChinaZ.com)4月4日 消息:多家科技巨头正在扎堆构建大型语言模型,但最让人感到意外的一家公司可以说是是金融数据和新闻行业巨头彭博。

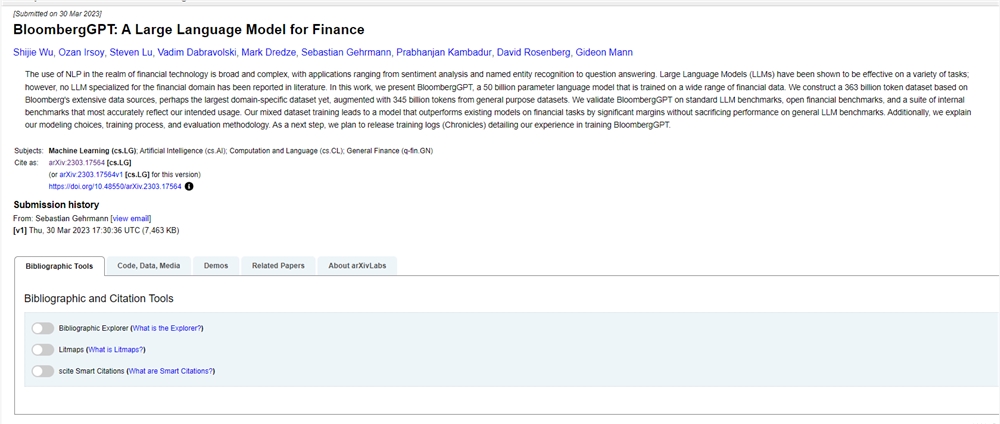

彭博由前纽约大佬 Mike Bloomberg 创立,是一家拥有量化新闻部门的金融数据公司,最近这家公司进军了AI大型语言模型领域,推出了BloombergGPT。该公司表示,该大语言模型(LLM)专门针对各类金融数据进行训练,以全方位支持金融领域的自然语言处理(NLP)任务。

彭博表示,基于LLM的人工智能(AI)已经在许多领域都展示出令人兴奋的新应用。然而,由于金融行业的复杂性并且含有大量金融术语,仍需要一个专攻金融专业的模型。

BloombergGPT 将用于金融 NLP 任务,例如情绪分析、命名实体识别、新闻分类和问答。

该模型还将用于引入挖掘彭博终端(Bloomberg Terminal)海量数据的新方法。多年来,彭博终端一直使用功能键和复杂的用户界面。

Bloomberg 首席技术官 Shawn Edwards 在一篇博客中表示,与为每个应用程序创建自定义模型相比,BloombergGPT 将使公司能够更快地处理新型应用程序,一开始就具有“更高的性能”。

BloombergGPT到底如何呢?

就训练规模而言,BloombergGPT 由500亿个参数组成。相比之下 OpenAI 的GPT-3使用了1750亿个参数。

在 LLM中,BloombergGPT 还是相对较小,与其相近的是 Meta 的650亿参数的LLaMA 模型。当然,BloombergGPT 是专门针对高度特定的金融 NLP 任务进行训练的,这意味着它不需要像 OpenAI 模型那样更通用的数据。

该模型是通过使用 Bloomberg 广泛的金融数据存档创建的,包含3,630亿词例(token)的金融数据集,这批数据又与另一个包含3,450亿词例的公共数据集叠加,成为了包含超7,000亿词例的大型训练语料库。

Bloomberg ML 工程师随后训练了一个500亿参数的仅解码器因果语言模型,生成的模型在特定于金融的 NLP 基准以及一套内部标准上进行了验证。

就BIG-bench Hard和MMLU等流行的 NLP基准而言,彭博社表示,BloombergGPT模型在金融任务上的表现远超类似规模的开放模型,而在一般NLP基准上的表现也达到甚至超过了平均水平。

对于特定于金融的基准测试,BloombergGPT 可以与更大的开源模型相媲美,例如Bloom和OPT-66B。Bloomberg 的得分也高于 Hugging Face 的GPT-NeoX等较小的开源模型。

然而,在更一般的基准测试中,BloombergGPT 对比 OpenAI 的 GPT-3,只取得了相差不远的结果。

BloombergGPT在两大类NLP任务中的表现:金融专业任务和一般任务。

LLM池塘来了一条新鱼

OpenAI和谷歌正在使用他们的大型语言模型来为代码生成和生产工作流程改进等任务提供新的产品。

但随着对 LLM 兴趣的增加,开发自家模型的玩家数量也在增加。就在上周,芯片制造初创公司 Cerebras推出了在其 AI 超级计算机 Andromeda 上训练的大型语言模型。Salesforce为客户关系管理创建了EinsteinGPT 。

训练这些模型的巨大成本可能会让很多企业放弃开发自己的模型。

但也有例外,比如斯坦福大学的 AI 研究人员推出了语言模型Alpaca,其训练成本仅为600美元。另外一个例子是,Databricks 展示了开发成本仅需30美元的ChatGPT 克隆版Dolly 。

然而在大家扎堆开发大语言模型的背景下,马斯克等千名科技人士签署公开信,呼吁暂停训练比GPT-4更强大的AI系统,以研究它们的影响。这封公开信由非营利性组织Future of Life Institute发布,信的开头写道:“广泛的研究表明,具有与人类竞争智能的AI系统可能会对社会和人类造成深远的风险,这一点也得到了顶级AI实验室的承认。”公开信指出:“只有在我们确信它们的效果是积极的,风险是可控的,才应该开发强大的人工智能系统。”

然而,这个想法遭到了图灵奖获得者 Yann LeCun 等人的嘲笑。

(举报)